Xiaomi MiMo是什么?

MiMo 是小米推出的首個開源推理大語言模型,參數規模為 7B,聚焦于數學推理與代碼生成任務。該模型通過高推理密度的預訓練數據(總計 25 萬億 tokens)與強化學習后訓練(包括獎勵機制優化、樣本再采樣策略等),實現了在 AIME、LiveCodeBench 等多個權威基準上的領先表現。在同等訓練資源下,MiMo 在推理能力上超越了部分 30B 級別模型,如 Qwen-32B 和 DeepSeek-R1,展示了中型模型在結構優化與訓練策略驅動下的強大潛力,也標志著小米正式進軍開源大模型領域。

Xiaomi MiMo 的主要特點

- 專為推理任務設計

MiMo 聚焦于數學推理與代碼生成兩大“硬邏輯”場景,具備優異的邏輯思維能力,適用于高階復雜任務。 - 中等規模,高性能

雖為 7B 參數模型,但在多個權威基準(如 AIME、LiveCodeBench、MATH500)中表現優于部分 30B 模型,如 Qwen-32B 和 DeepSeek-R1,性價比高。 - 創新的數據與訓練策略

- 使用三階段 curriculum-style 訓練流程,逐步提高訓練難度

- 構建并合成高達 200B tokens 的推理語料,總訓練量達 25T tokens

- 引入 Multiple Token Prediction(MTP),提高模型生成效率和準確率

- 強化學習優化(RLHF)先進

- 構建 13 萬道可驗證數學與代碼題

- 提出 Test Difficulty Driven Reward,解決稀疏獎勵問題

- 引入 Easy Data Re-Sampling 策略,提升 RL 收斂速度與穩定性

- 訓練系統 Seamless Rollout Engine 提速訓練 2.29×、驗證 1.96×

- 完全開源,透明開放

提供基礎模型(Base)、監督微調(SFT)與強化學習(RL)版本,配套完整技術報告,支持在 Hugging Face 下載和本地部署。

Xiaomi MiMo 模型版本對比

| 模型名稱 | 描述 | Hugging Face 地址 |

|---|---|---|

| MiMo-7B-Base | 預訓練基礎模型,具備原生推理能力 | ?? MiMo-7B-Base |

| MiMo-7B-SFT | 基于 Base 模型的監督微調版本 | ?? MiMo-7B-SFT |

| MiMo-7B-RL-Zero | 從 Base 模型直接 RL 微調 | ?? MiMo-7B-RL-Zero |

| MiMo-7B-RL | 在 SFT 基礎上進行 RL 微調,性能最強 | ?? MiMo-7B-RL |

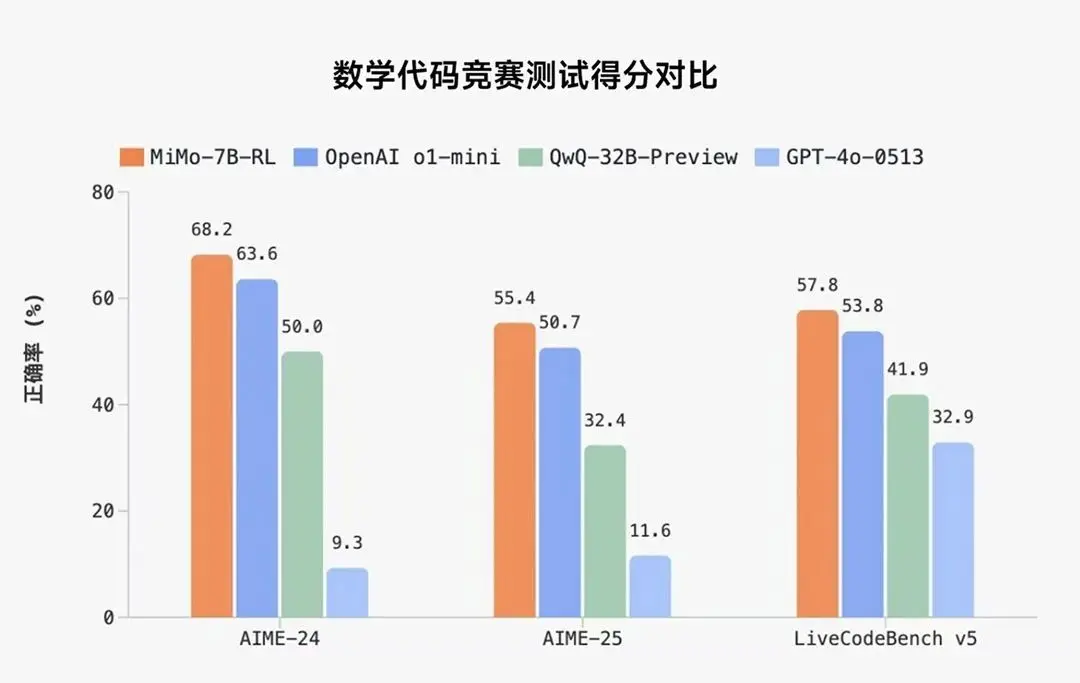

Xiaomi MiMo 的性能評測

在數學推理(AIME 24-25)和代碼競賽(LiveCodeBench v5)上超越在 STEM 領域(科學、技術、工程和數學)表現出色的 OpenAI o1-mini 和 Qwen-32B-Preview。

在相同 RL 訓練數據情況下,MiMo-7B 的數學&代碼領域的強化學習潛力超越 DeepSeek-R1-Distill-7B 和 Qwen2.5-32B。

Xiaomi MiMo 的項目地址

目前,MiMo-7B 已在 Hugging Face 平臺開源 4 個模型版本,技術報告也同步上線 GitHub,向開發者與研究者全面開放。

- GitHub倉庫:https://github.com/XiaomiMiMo/MiMo/tree/main

- HuggingFace模型地址:https://huggingface.co/XiaomiMiMo

- GitHub 技術報告:https://github.com/XiaomiMiMo/MiMo/blob/main/MiMo-7B-Technical-Report.pdf

?版權聲明:如無特殊說明,本站所有內容均為AIHub.cn原創發布和所有。任何個人或組織,在未征得本站同意時,禁止復制、盜用、采集、發布本站內容到任何網站、書籍等各類媒體平臺。否則,我站將依法保留追究相關法律責任的權利。