MiniMax-M1是什么?

MiniMax-M1 是MiniMax(稀宇科技)推出的全球首個開源大規模混合架構推理模型,具備卓越的長上下文處理能力和高效的推理性能。其支持高達100萬上下文輸入和8萬Token輸出,采用閃電注意力機制,顯著提升算力效率。同時,該模型在軟件工程、長上下文理解等復雜場景中表現優異,性價比極高,且提供免費不限量使用和低價格API服務。

MiniMax-M1的技術優勢

- 大規模上下文輸入與推理輸出

- 支持高達100萬上下文的輸入,與 Google Gemini 2.5 Pro 相當,是 DeepSeek R1 的8倍。

- 提供業內最長的8萬Token的推理輸出。

- 這主要得益于其獨創的閃電注意力機制為主的混合架構,在處理長上下文輸入和深度推理時表現出顯著的高效性。例如,在8萬Token深度推理時,僅需使用 DeepSeek R1 約30%的算力。

- 高效的強化學習算法

- 提出了更快的強化學習算法 CISPO,通過裁剪重要性采樣權重(而非傳統 token 更新)提升強化學習效率。

- 在 AIME 實驗中,該算法的收斂性能比字節近期提出的 DAPO 等強化學習算法快一倍,顯著優于 DeepSeek 早期使用的 GRPO。

- 整個強化學習階段僅用512塊 H800 三周時間,租賃成本僅53.74萬美金,比預期少了一個數量級。

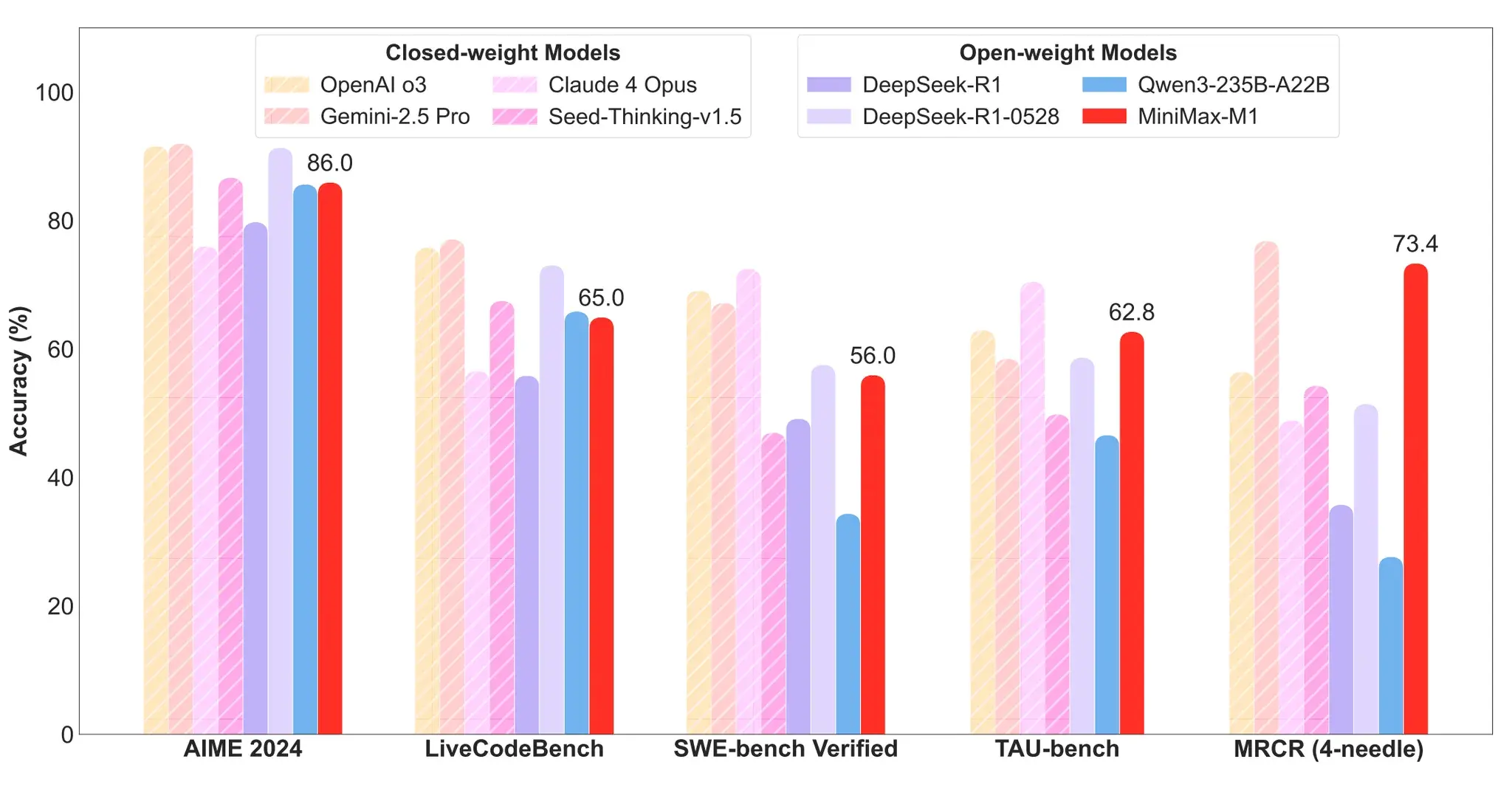

MiniMax-M1的性能表現

- 軟件工程場景:MiniMax-M1-40k 和 MiniMax-M1-80k 在 SWE-bench 驗證基準上分別取得55.6%和56.0%的成績,略遜于 DeepSeek-R1-0528 的57.6%,但顯著超越其他開源權重模型。

- 長上下文理解任務:依托百萬級上下文窗口,M1 系列在長上下文理解任務中表現卓越,全面超越所有開源權重模型,甚至超越 OpenAI o3 和 Claude 4 Opus,全球排名第二,僅以微弱差距落后于 Gemini 2.5 Pro。

- 代理工具使用場景

- MiniMax-M1-40k 在 TAU-bench 中領跑所有開源權重模型,并戰勝 Gemini-2.5 Pro。

- MiniMax-M1-80k 在大多數基準測試中始終優于 MiniMax-M1-40k,驗證了擴展測試時計算資源的有效性。

如何使用MiniMax-M1?

1、普通用戶

MiniMax-M1已經在MiniMax Web 和 APP 上都保持不限量免費使用。

2、企業和開發者

MiniMax開發者平臺提供業內最低價格的 API 服務:

- 0-32k 輸入長度:輸入0.8元/百萬 token,輸出8元/百萬 token。

- 32k-128k 輸入長度:輸入1.2元/百萬 token,輸出16元/百萬 token。

- 128k-1M 輸入長度:輸入2.4元/百萬 token,輸出24元/百萬 token。

前兩種模式性價比高于 DeepSeek-R1,后一種模式 DeepSeek 模型不支持。

3、開源與部署

- 在線體驗:https://chat.minimax.io/

- Hugging Face:https://huggingface.co/MiniMaxAI

- GitHub:https://github.com/MiniMax-AI/MiniMax-M1

- 技術報告:https://arxiv.org/abs/2506.13585

?版權聲明:如無特殊說明,本站所有內容均為AIHub.cn原創發布和所有。任何個人或組織,在未征得本站同意時,禁止復制、盜用、采集、發布本站內容到任何網站、書籍等各類媒體平臺。否則,我站將依法保留追究相關法律責任的權利。