Phi-3 是什么?

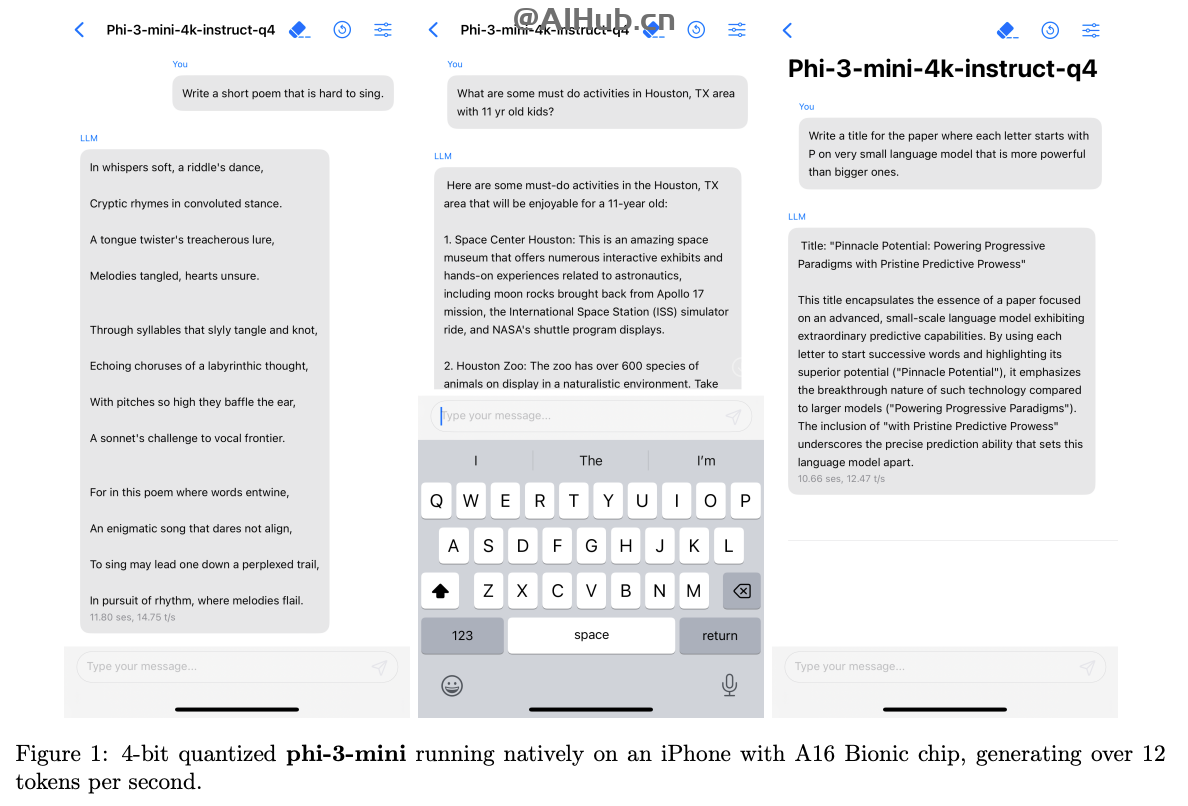

Phi-3 是微軟 AI 研究院公布的一系列小型語言模型,開源可商用。Phi-3 系列包括三種模型:Phi-3-Mini、Phi-3-Small 和 Phi-3-Medium,它們在保持較小模型尺寸的同時,還能提供與大型模型相媲美的性能。這些模型特別適合于需要快速響應和低延遲的應用場景,同時還能減少對帶寬和存儲的需求,例如在移動設備或者邊緣計算設備上。

Phi-3模型組成:

- Phi-3-mini:mini是3.8B 的參數(shù),3.3T token 訓練數(shù)據(jù)。在多個學術(shù)基準測試中,Phi-3-mini 性能接近或等同于市場上的大型模型,例如在 MMLU 測試中得分為 69%,在 MT-bench 測試中得分為 8.38 分。

- Phi-3-small:Small 是 7B 參數(shù),4.8T token 訓練數(shù)據(jù),MMLU 75%,MT-bench 8.7 分。?

- Phi-3-medium: Medium 是 14B 參數(shù),4.8T token 訓練數(shù)據(jù),MMLU 78%,MT-bench ?8.9 分。

Phi-3的模型特色和優(yōu)勢

- 小型化:Phi-3 模型的體積小,特別是 Phi-3-Mini,只有 3.8B 參數(shù),這使得模型可以在資源受限的設備上運行。

- 高性能:盡管模型小型化,Phi-3 在多個學術(shù)基準測試中表現(xiàn)出接近或等同于市場上大型模型的性能。

- 快速響應:Phi-3-Mini 能夠在 iPhone 上每秒生成 16 個 token 的信息,這意味著它可以在移動設備上實現(xiàn)快速響應。

- 離線能力:Phi-3 模型支持離線運行,不需要互聯(lián)網(wǎng)連接,這有助于保護用戶隱私并減少對網(wǎng)絡帶寬的依賴。

- 多語言支持:Phi-3 的 Small 和 Medium 版本包含了多語言數(shù)據(jù),雖然 Phi-3-Mini 主要處理英文,但未來可能會支持更多語言。

- 節(jié)省資源:Phi-3 的內(nèi)存占用相對較低,這使得它能夠在配置較低的設備上運行,而不會顯著影響設備性能。

- 易于集成:由于其小型化和高效性,Phi-3 模型可以輕松集成到各種應用中,包括移動應用、嵌入式系統(tǒng)和物聯(lián)網(wǎng)設備。

- 定制應用:小型模型如 Phi-3 更適合于定制化應用,特別是對于那些數(shù)據(jù)集較小或需要特定領(lǐng)域優(yōu)化的企業(yè)。

- 成本效益:相比于大型模型,小型模型通常在計算資源和能源消耗上更為經(jīng)濟,有助于降低運營成本。

- 易于部署:小型模型易于在本地設備上部署,有助于實現(xiàn)快速的數(shù)據(jù)處理和響應,同時減少對云服務的依賴。

Phi-3 模型的這些優(yōu)勢使其成為在資源受限或需要快速、本地化處理的自然語言處理應用中的理想選擇。

Phi-3的技術(shù)框架

- Transformer 解碼器架構(gòu):Phi-3-Mini 采用了為移動設備優(yōu)化的架構(gòu),支持通過 LongRope 系統(tǒng)擴展上下文長度。

- 結(jié)構(gòu)設計:Phi-3-Mini 與 Llama-2 模型結(jié)構(gòu)相似,使用了相同的分詞器,保證了與 Llama-2 系列軟件包的兼容性。

- 分組查詢和塊狀稀疏注意力機制:Small 和 Medium 版本引入了這些機制,以優(yōu)化長期上下文檢索性能并減少內(nèi)存占用。

- 數(shù)據(jù)訓練:使用網(wǎng)頁數(shù)據(jù)和合成數(shù)據(jù)進行訓練,分為兩個階段,第一階段注重通用知識和語言理解,第二階段培養(yǎng)邏輯推理和特定技能。

- 訓練方法:Phi-3 的訓練方法受到兒童學習方式的啟發(fā),采用“課程”式訓練,使用簡化的“兒童讀物”來教導模型。

如何使用Phi-3?

微軟提供了Phi-3的技術(shù)報告、在線體驗和模型下載地址:

- 在線體驗地址:https://huggingface.co/chat/models/microsoft/Phi-3-mini-4k-instruct

- 模型下載地址:https://huggingface.co/collections/microsoft/phi-3-6626e15e9585a200d2d761e3

- 技術(shù)報告鏈接:https://arxiv.org/abs/2404.14219

總之,Phi-3 系列模型的推出,展示了微軟在小型化、高效能語言模型領(lǐng)域的最新進展,特別是在移動設備上的應用潛力。

?版權(quán)聲明:如無特殊說明,本站所有內(nèi)容均為AIHub.cn原創(chuàng)發(fā)布和所有。任何個人或組織,在未征得本站同意時,禁止復制、盜用、采集、發(fā)布本站內(nèi)容到任何網(wǎng)站、書籍等各類媒體平臺。否則,我站將依法保留追究相關(guān)法律責任的權(quán)利。