DCLM-7B是什么?

DCLM-7B是蘋果與合作伙伴一起推出的開源小型語言模型,全部開源,包括權重、訓練代碼和數據集。DCLM-7B性能優異,接近大型模型,采用decoder-only架構,上下文長度2048。DCLM-7B在多個基準任務上性能出色,支持商業使用。

DCLM-7B的主要特性

- 模型規格:DCLM-7B 基礎模型是在 2.5 萬億個詞庫上訓練出來的,主要使用英語數據,上下文窗口為 2048。

- 訓練數據集:結合來自 DCLM-BASELINE、StarCoder 和 ProofPile2 的數據集。

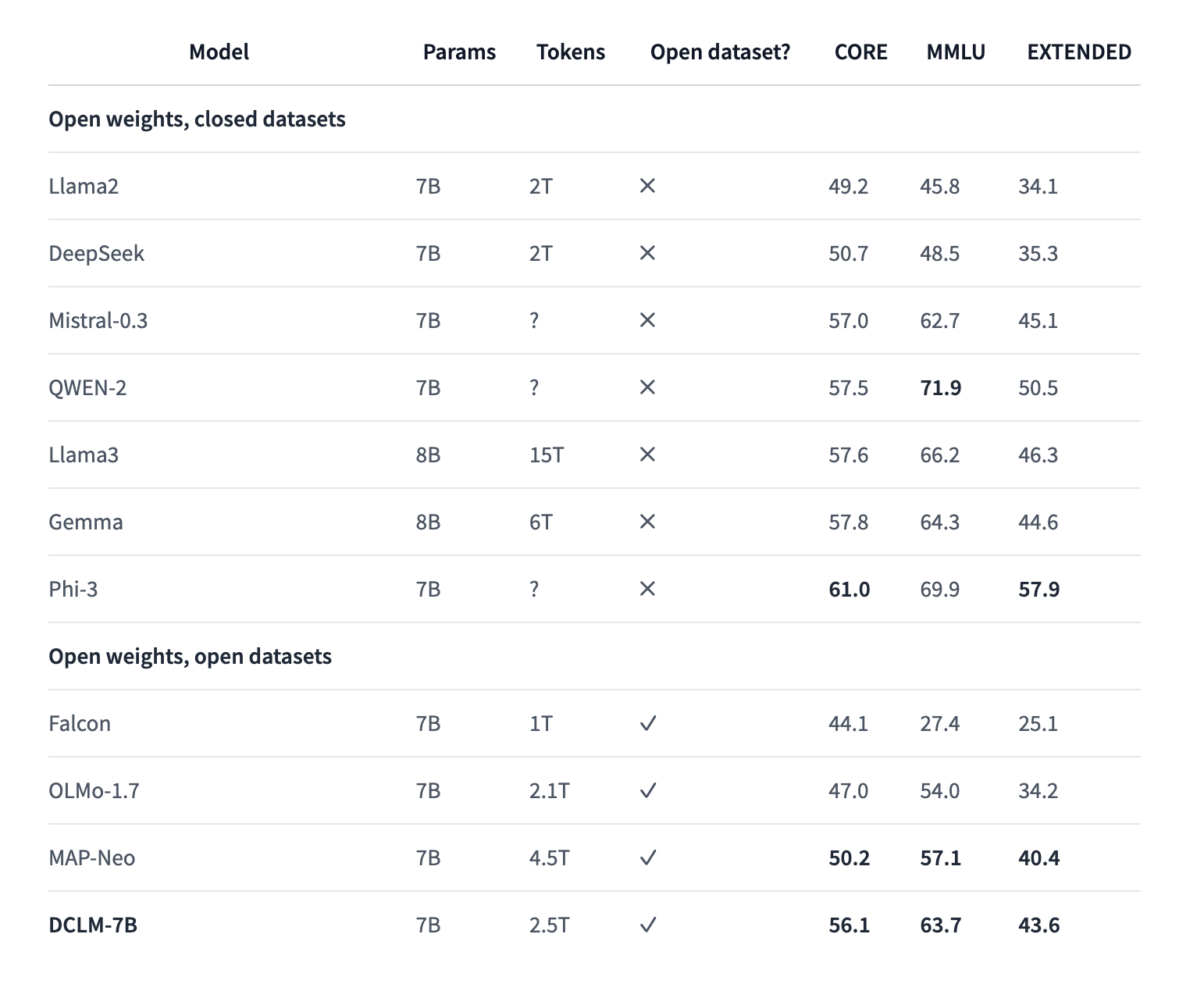

- 性能表現:該模型的 MMLU 得分為 0.6372,性能高于 Mistral,但低于 Llama3。

- 訓練框架:使用 PyTorch 和 OpenLM 框架開發。

- 許可證:根據開放許可證發布,特別是蘋果示例代碼許可證。

- 可用性:目前,HuggingFace上已經發布了全部模型權重。

DCLM-7B的性能評測

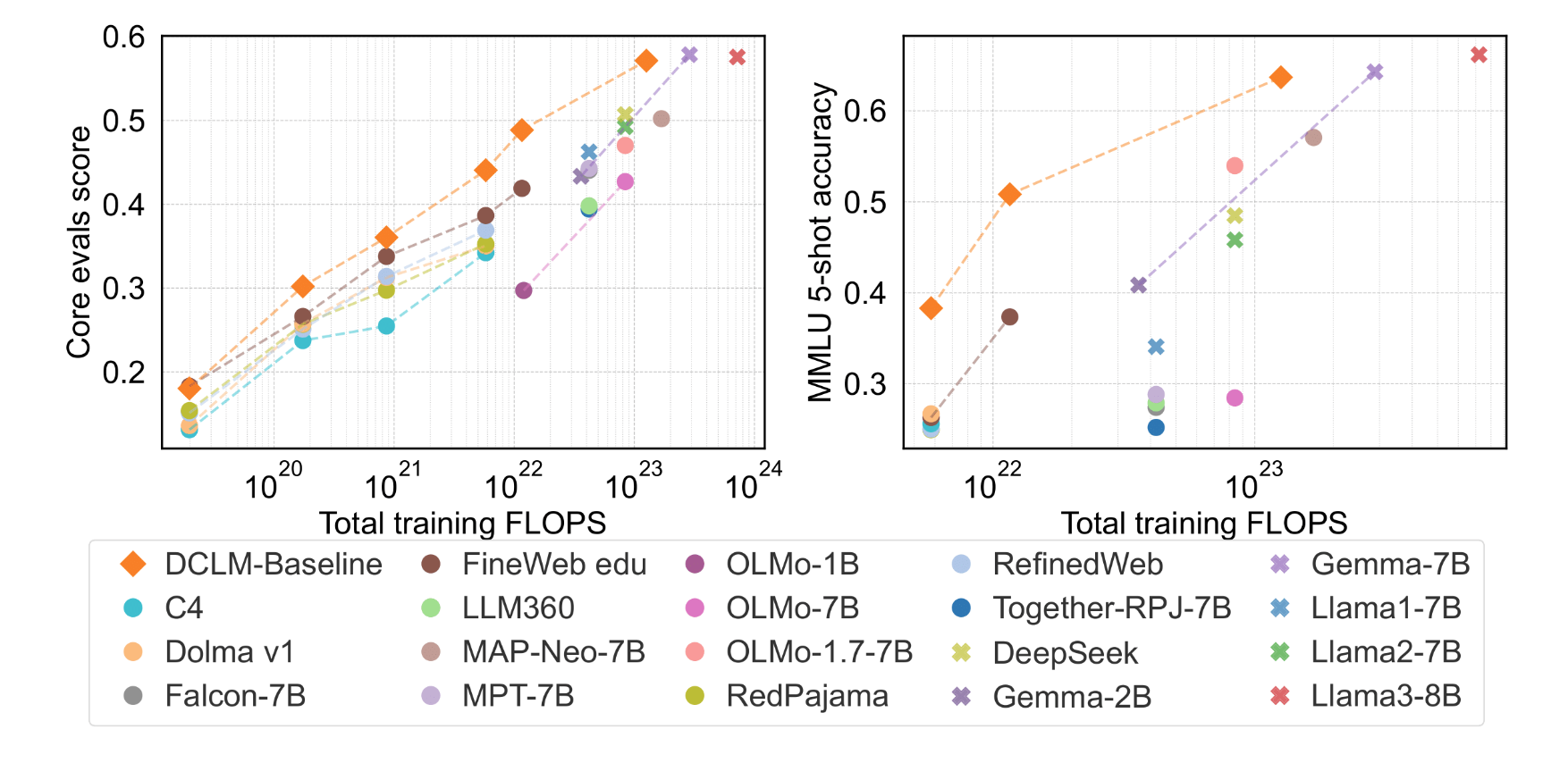

DCLM-7B在MMLU基準上5-shot準確率達64%,可與Mistral-7B-v0.3(63%)和Llama3-8B(66%)相媲美;并且在53個自然語言理解任務上的平均表現也可與Llama 3 8B相媲美,而所需計算量僅為后者的1/6。

與其他同等大小模型相比,DCLM-7B的MMLU得分超越Mistral-7B,接近Llama 3 8B。

如何使用DCLM-7B?

目前,HuggingFace上已經發布了全部模型權重,其中的模型卡已經基本涵蓋了關鍵信息。

- 模型地址:https://huggingface.co/apple/DCLM-7B

- GitHub:https://github.com/mlfoundations/dclm

- 數據集:https://huggingface.co/datasets/mlfoundations/dclm-baseline-1.0

- 論文:https://arxiv.org/pdf/2406.11794

?版權聲明:如無特殊說明,本站所有內容均為AIHub.cn原創發布和所有。任何個人或組織,在未征得本站同意時,禁止復制、盜用、采集、發布本站內容到任何網站、書籍等各類媒體平臺。否則,我站將依法保留追究相關法律責任的權利。