Emu3是什么?

Emu3是由北京智源研究院推出的原生多模態(tài)世界模型,旨在簡(jiǎn)化和提升多模態(tài)任務(wù)的處理能力。多模態(tài)任務(wù)指的是同時(shí)處理不同類型的數(shù)據(jù)(如圖像、視頻、文本等)。與依賴擴(kuò)散模型(如 Stable Diffusion)或組合架構(gòu)(如 CLIP 與大型語(yǔ)言模型結(jié)合)的傳統(tǒng)方法不同,Emu3 采用了 next-token 預(yù)測(cè)技術(shù),將圖像、文本、視頻轉(zhuǎn)化為離散的 token,并使用單一的 Transformer 模型進(jìn)行訓(xùn)練。

Emu3只基于下一個(gè) token 預(yù)測(cè),無(wú)需擴(kuò)散模型或組合方法,即可完成文本、圖像、視頻三種模態(tài)數(shù)據(jù)的理解和生成,官方宣稱實(shí)現(xiàn)圖像、文本、視頻大一統(tǒng)。

Emu3的功能特性

- 圖像生成:Emu3 通過預(yù)測(cè)視覺 token 來生成高質(zhì)量圖像,支持靈活的分辨率和風(fēng)格,不再需要擴(kuò)散模型,生成過程更為高效。

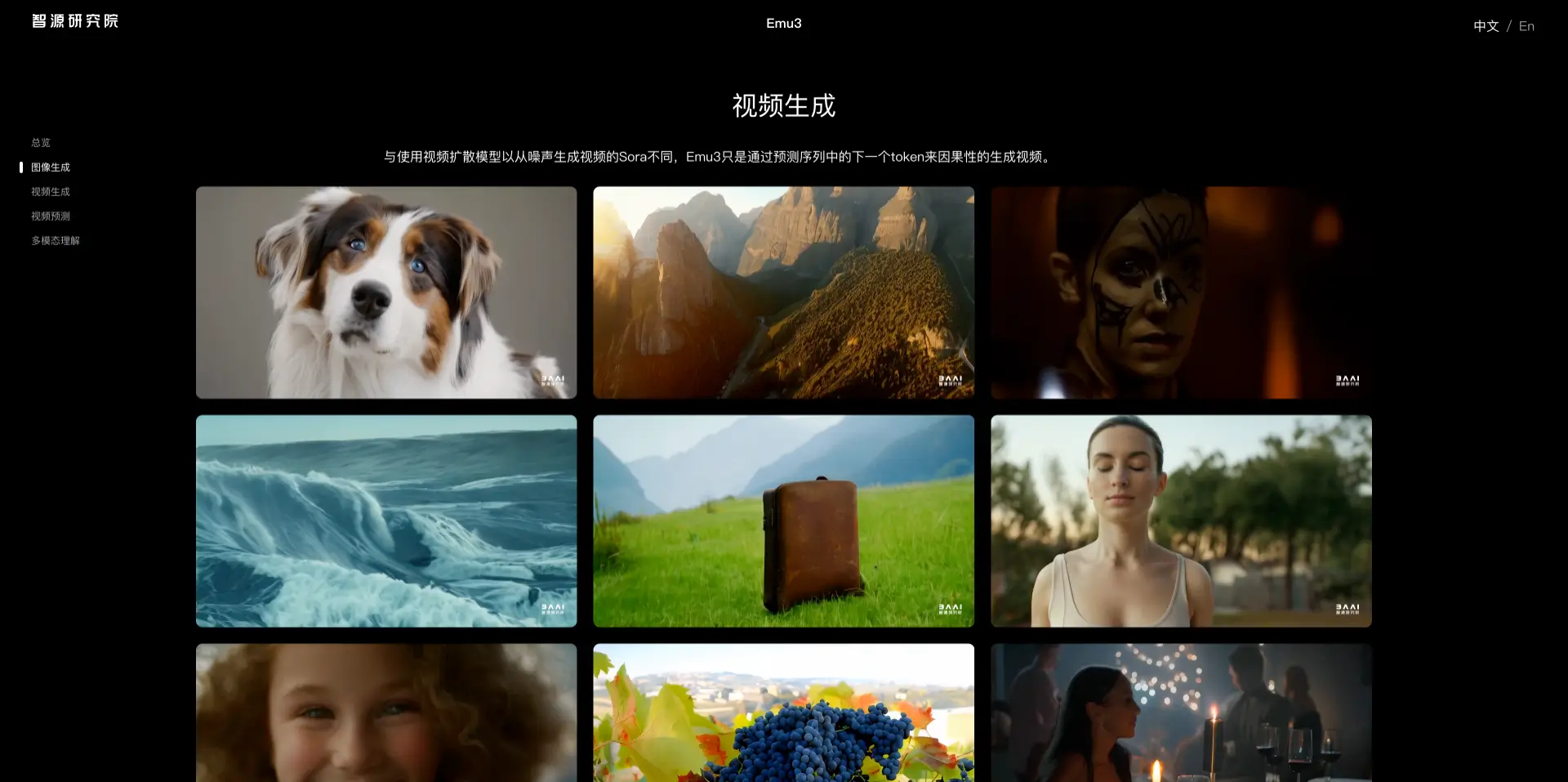

- 視頻生成:與依賴噪聲生成視頻的擴(kuò)散模型不同,Emu3 通過預(yù)測(cè)視頻序列中的下一個(gè) token 來生成視頻,使整個(gè)過程更加簡(jiǎn)潔高效。

- 視頻預(yù)測(cè):Emu3 能夠?qū)σ曨l進(jìn)行延續(xù)預(yù)測(cè),模擬現(xiàn)實(shí)世界中的環(huán)境、人物和動(dòng)物行為,展現(xiàn)強(qiáng)大的物理世界模擬能力。

- 視覺-語(yǔ)言理解:Emu3 展現(xiàn)了強(qiáng)大的視覺和語(yǔ)言感知能力,可以對(duì)圖像進(jìn)行詳細(xì)描述,并提供連貫的文本回復(fù),而無(wú)需依賴 CLIP 和預(yù)訓(xùn)練的大型語(yǔ)言模型。

- 多模態(tài)整合:Emu3 通過將文本、圖像和視頻轉(zhuǎn)化為離散 token,并統(tǒng)一使用 Transformer 進(jìn)行訓(xùn)練,實(shí)現(xiàn)了多模態(tài)數(shù)據(jù)的整合。該模型能夠在多個(gè)領(lǐng)域(圖像、視頻、文本)表現(xiàn)出色,并且可以同時(shí)處理這些不同模態(tài)的數(shù)據(jù),適用于多模態(tài)任務(wù)。

- 無(wú)擴(kuò)散、無(wú)組合架構(gòu):Emu3 的設(shè)計(jì)拋棄了傳統(tǒng)的擴(kuò)散模型和組合架構(gòu),專注于 token 預(yù)測(cè)。這種設(shè)計(jì)使得模型在訓(xùn)練和推理過程中能夠更高效地?cái)U(kuò)展。減少了對(duì)傳統(tǒng)復(fù)雜架構(gòu)的依賴,提高了模型的可擴(kuò)展性,適用于更多任務(wù)和更大規(guī)模的數(shù)據(jù)集。

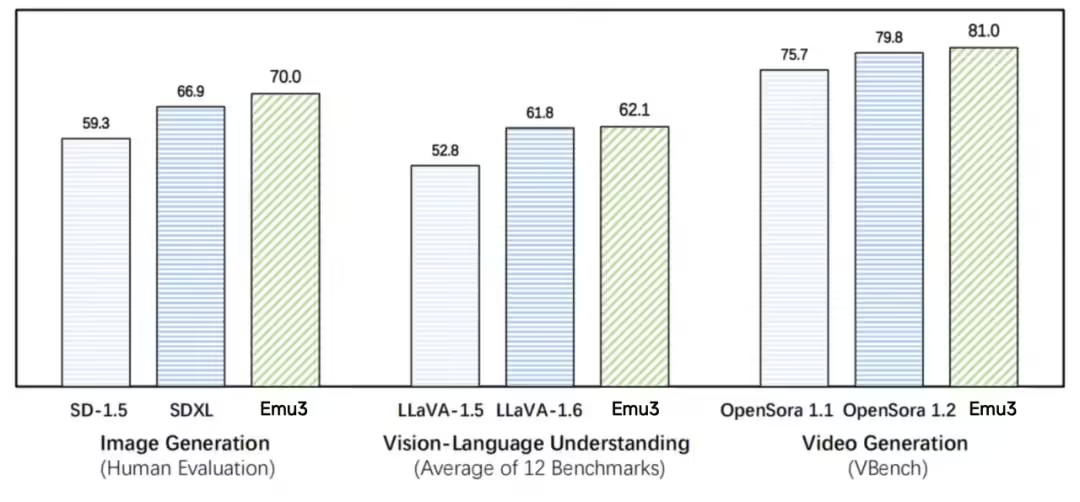

Emu3的性能評(píng)測(cè)

在圖像生成任務(wù)中,基于人類偏好評(píng)測(cè),Emu3 優(yōu)于 SD-1.5 與 SDXL 模型。在視覺語(yǔ)言理解任務(wù)中,對(duì)于 12 項(xiàng)基準(zhǔn)測(cè)試的平均得分,Emu3 優(yōu)于 LlaVA-1.6。在視頻生成任務(wù)中,對(duì)于 VBench 基準(zhǔn)測(cè)試得分,Emu3 優(yōu)于 OpenSora 1.2。

如何使用Emu3?

目前 Emu3 已開源了關(guān)鍵技術(shù)和模型,鏈接如下:

- Emu3 官網(wǎng):https://emu.baai.ac.cn/

- Emu3 代碼:https://github.com/baaivision/Emu3

- Emu3 模型:https://huggingface.co/collections/BAAI/emu3-66f4e64f70850ff358a2e60f