Grok-1是什么?

Grok-1是馬斯克旗下AI公司xAI發布的開源AI大模型,其參數量達到了3140億,遠超OpenAI GPT-3.5的1750億。這是迄今參數量最大的開源大語言模型,遵照Apache 2.0協議開放模型權重和架構。

Grok-1是一個混合專家(Mixture-of-Experts,MOE)大模型,這種MOE架構重點在于提高大模型的訓練和推理效率,形象地理解,MOE就像把各個領域的“專家”集合到了一起,遇到任務派發給不同領域的專家,最后匯總結論,提升效率。決定每個專家做什么的是被稱為“門控網絡”的機制。

Grok-1模型的公開發布,為研究人員和開發者提供了一個新的大型語言模型資源。

Grok-1的主要特性

xAI還特別強調了Grok-1的幾大特性:

- 首先,Grok-1是一個未針對特定任務進行微調的基礎模型,它基于大量文本數據訓練而成;

- 其次,作為一款基于混合專家技術構建的大語言模型,Grok-1擁有3140億參數,在處理每個token時有25%的權重處于活躍狀態;

- 最后,Grok-1是xAI團隊使用JAX和Rust編程語言自定義訓練棧從零開始訓練的成果,訓練完成于2023年10月。

Grok-1的技術參數

基礎信息:

模型大小:3140億參數,其中混合了8名專家(2名活躍)

活動參數:860億

特色技術:使用旋轉嵌入(Rotary Embeddings,簡稱#rope),而非固定位置嵌入

模型結構細節:

分詞器詞匯量:131,072(與GPT-4相似),即2^17

嵌入尺寸:6,144(48*128)

架構層數:64層變壓器層

每層結構:包含一個解碼器層,具有多頭注意力塊和密集塊

鍵值大小:128

多頭注意力塊:

查詢頭數量:48

鍵/值(KV)頭數量:8

KV大小:128

密集塊(Dense Block):

加寬系數:8

隱藏層大小:32,768

每個代幣從8名專家中選擇2名

旋轉位置嵌入:

尺寸:6,144,與模型的輸入嵌入大小相同

上下文長度:8,192個標記

精度:bf16

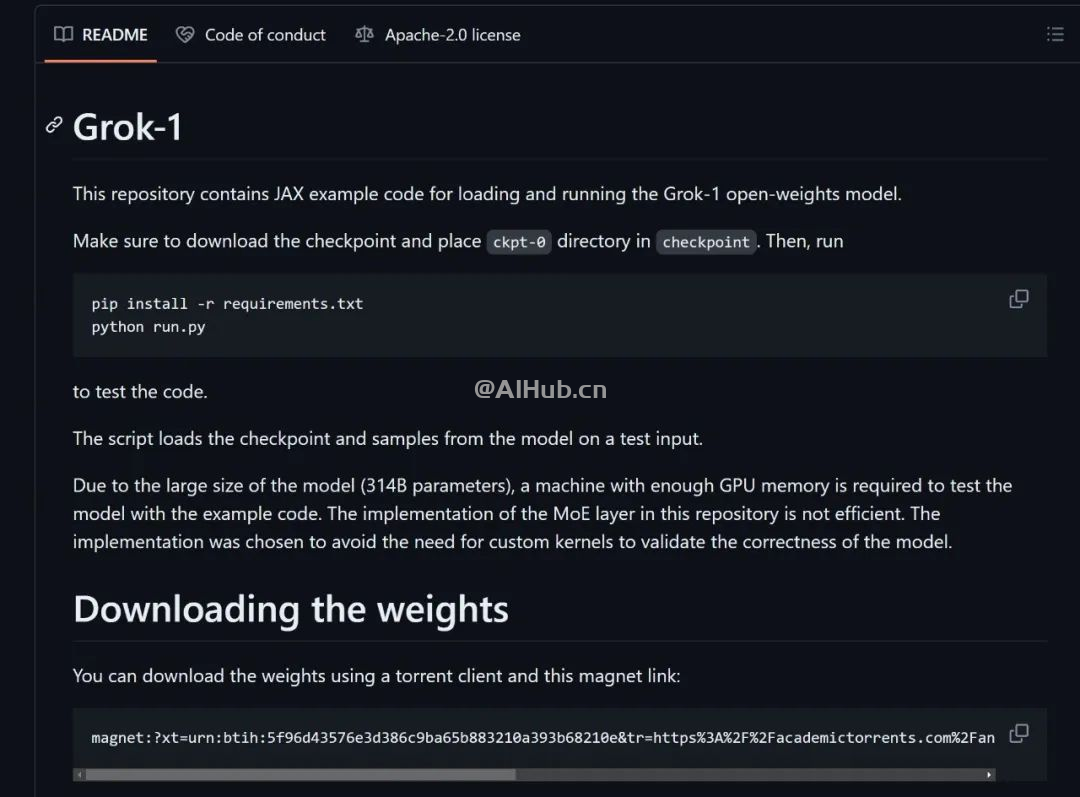

如何使用Grok-1?

xAI已經將Grok-1的權重和架構在GitHub上開源。

GitHub地址:https://github.com/xai-org/grok-1

?版權聲明:如無特殊說明,本站所有內容均為AIHub.cn原創發布和所有。任何個人或組織,在未征得本站同意時,禁止復制、盜用、采集、發布本站內容到任何網站、書籍等各類媒體平臺。否則,我站將依法保留追究相關法律責任的權利。