Hunyuan-Large是什么?

Hunyuan-Large是騰訊混元最新開源的 MoE 大模型,Hunyuan-Large 擁有 3890 億總參數量、520 億激活參數量,并支持 256K 上下文長度,是目前業界參數規模最大、性能領先的開源 MoE 模型。

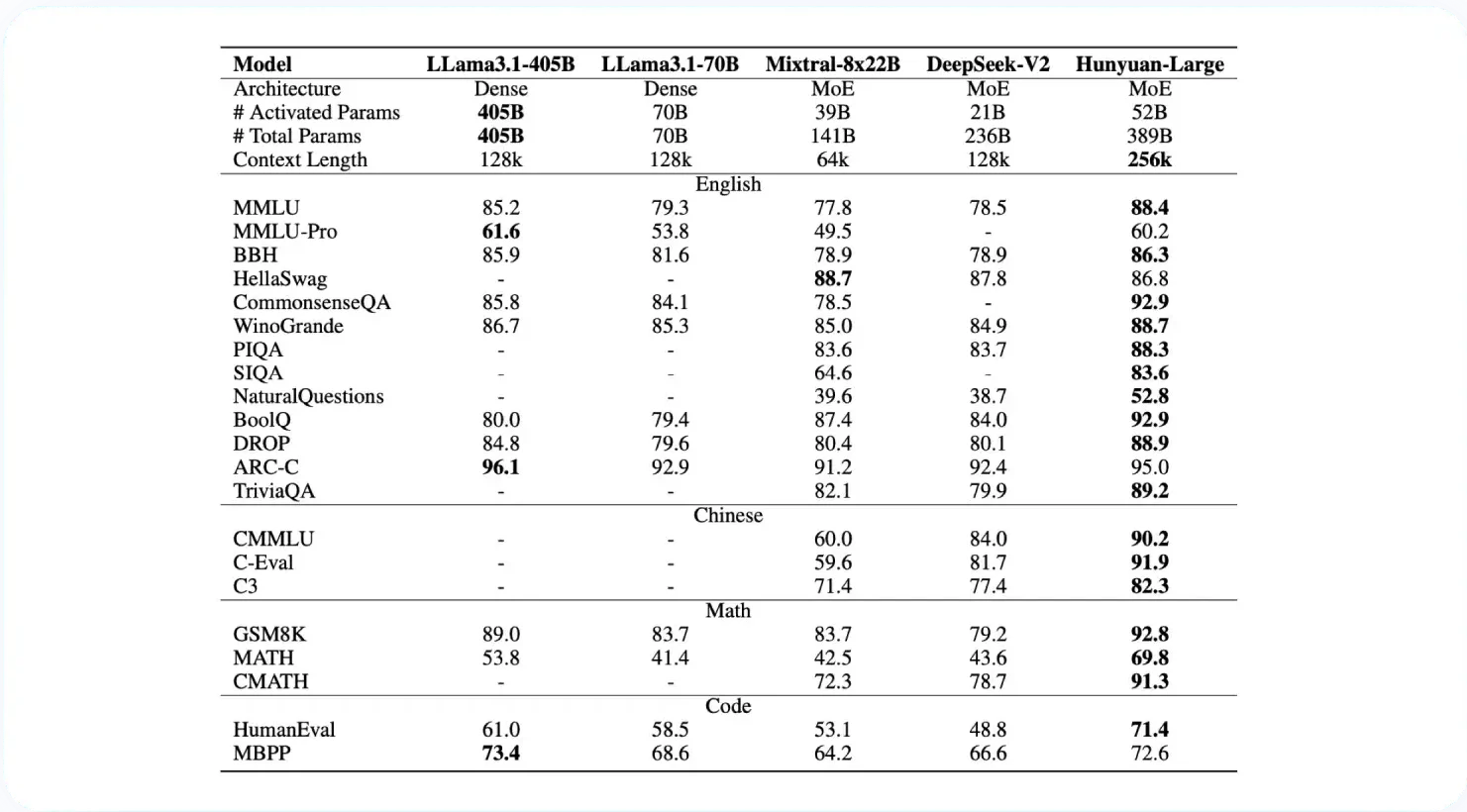

基于 MoE(Mixture of Experts)結構的優越性,混元 Large 在推理速度和參數規模之間取得平衡,顯著提升了模型的處理能力。測試結果顯示,Hunyuan-Large 在 CMMLU、MMLU、CEval、AGIEval 等多學科評測集以及中英文 NLP 任務、代碼、數學等9大維度表現出色,超越 Llama3 和 Mixtral 等主流開源模型。

Hunyuan-Large的模型特性

- 高質量合成數據:通過加強合成數據的訓練,Hunyuan-Large 可以學習更豐富的表征,處理長上下文輸入,并更好地泛化到未見過的數據。

- KV 緩存壓縮:利用分組查詢關注 (GQA) 和跨層關注 (CLA) 策略,大幅減少 KV 緩存的內存使用量和計算開銷,從而提高推理吞吐量。

- 特定專家學習率縮放:為不同專家設置不同的學習率,以確保每個子模型都能有效地從數據中學習并提高整體性能。

- 長文本處理能力:預訓練模型支持高達 256K 的文本序列,而指導模型支持高達 128K 的文本序列,從而顯著增強了處理長文本任務的能力。

- 廣泛的基準測試:在各種語言和任務中進行廣泛的實驗,以驗證渾源大數據的實際有效性和安全性。

Hunyuan-Large的專項能力

高質量文本創作:Hunyuan-Large可提供高質量寫作、潤色、總結、創意生成等文本創作能力。

數學能力:提供數學計算表格公式及圖表生成等能力。

知識問答:模型具有較好的通用語義理解和知識儲備,可回復用戶知識性提問。

Hunyuan-Large的性能評估

Hunyuan-Large在與業界開源的DeepSeek-V2 、Llama3.1-70B、Llama3.1-405B以及Mixtral-8x22B的對比中,在CMMLU、MMLU、CEval等多學科綜合評測集、中英文NLP任務、代碼和數學等9大維度全面領先,處于行業領先水平。

如何使用Hunyuan-Large?

- 在線體驗Hunyuan-Large :https://huggingface.co/spaces/tencent/Hunyuan-Large

- GitHub代碼地址:https://github.com/Tencent/Tencent-Hunyuan-Large

- Huggingface模型倉庫:https://huggingface.co/tencent/Tencent-Hunyuan-Large

- Hunyuan-Large技術報告:https://arxiv.org/abs/2411.02265

- 騰訊云開發平臺:https://cloud.tencent.com/document/product/851/112032