Mistral NeMo是什么?

Mistral NeMo是由法國AI公司Mistral AI與NVIDIA合作開發(fā)的一個(gè)120億(12B)參數(shù)的小語言模型。它提供高達(dá)128k tokens的上下文窗口,并且在推理、世界知識(shí)和編碼準(zhǔn)確性方面達(dá)到了該規(guī)模模型的先進(jìn)水平。它使用標(biāo)準(zhǔn)架構(gòu),易于集成和使用,并且可以作為Mistral 7B的直接替代品。

Mistral NeMo的主要特性

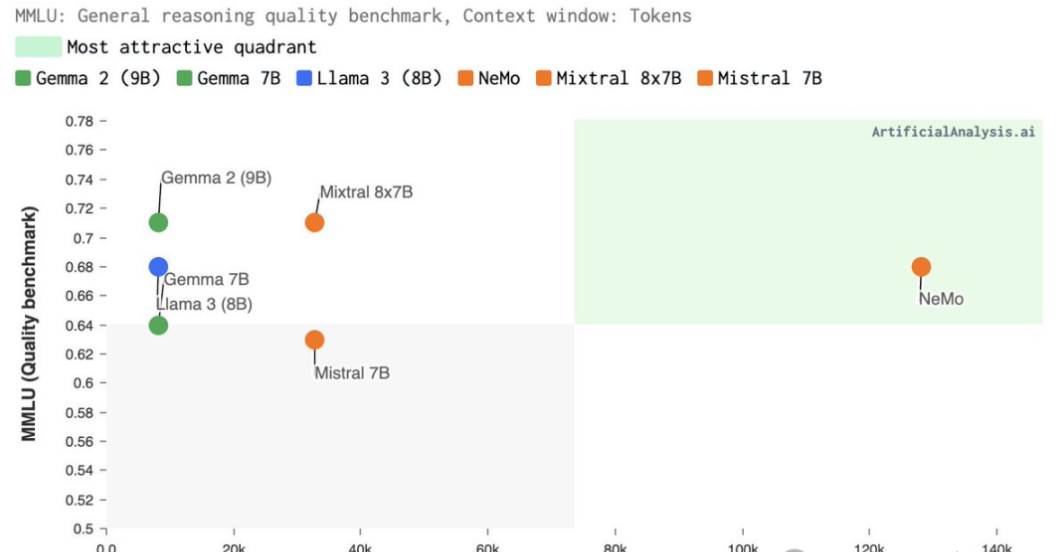

- 性能卓越:與同等參數(shù)規(guī)模模型相比,它的推理、世界知識(shí)和編碼準(zhǔn)確性都處于領(lǐng)先地位。

- 大上下文窗口:Mistral NeMo支持128K上下文,能夠更加連貫、準(zhǔn)確地處理廣泛且復(fù)雜的信息,確保輸出與上下文相關(guān)。

- 多語言支持:專為全球多語言應(yīng)用設(shè)計(jì),支持包括中文、英語、法語、德語、西班牙語、意大利語、葡萄牙語、日語、韓語、阿拉伯語和印地語在內(nèi)的多種語言。

- 指令微調(diào):Mistral NeMO 經(jīng)歷了高級(jí)微調(diào)和調(diào)整階段。與 Mistral 7B 相比,它在遵循精確指令、推理、處理多輪對(duì)話和生成代碼方面表現(xiàn)得更好。

- 開源許可:Mistral在Apache2.0許可證下發(fā)布了預(yù)訓(xùn)練的基本檢查點(diǎn)和指令微調(diào)檢查點(diǎn),允許商用。

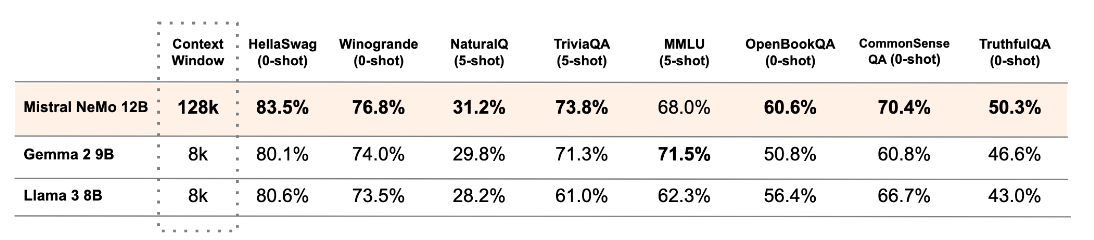

Mistral NeMo的性能評(píng)測

除了在MMLU基準(zhǔn)上,Mistral NeMo不如Gemma 2 9B。但在多輪對(duì)話、數(shù)學(xué)、常識(shí)推理、世界知識(shí)和編碼等基準(zhǔn)中,超越了Gemma 2 9B和Llama 3 8B。

如何使用Mistral NeMo?

Mistral NeMo權(quán)重文件已托管在HuggingFace上,提供了基礎(chǔ)模型和指令模型,可以通過mistral-inference試用,并用mistral-finetune適配。

- 基礎(chǔ)模型:https://huggingface.co/mistralai/Mistral-Nemo-Base-2407

- 指令模型:https://huggingface.co/mistralai/Mistral-Nemo-Instruct-2407

另外,用戶可以通過ai.nvidia.com作為NVIDIA NIM體驗(yàn)Mistral NeMo,可下載的NIM版本即將推出。